面對人工智能,我們應該擔心的不是機器消滅人類

按︰原文刊於2019年1月22日《明報》,此為加長版。

過去十年人工智能(AI)發展突飛猛進,帶來的技術改變亦已進入大眾視野,伴隨而來的自然還有恐懼。「AI失控」是不少科幻作品的背景設定,例如著名的《未來戰士》(Terminator)系列電影中,AI系統「天網」獲得自我意識後決定要滅絕人類。

這種恐懼亦能夠從新聞媒體中看到,2018年Facebook的人工智能研究團隊一項實驗中,發現其對話機械人未如預期般用正常英文交談,於是作出修改,卻被扭曲成「AI發展出秘密語言,Facebook被迫終止實驗」的假新聞,而且在Facebook上廣傳。此外還有一些科學、科技意見領袖亦警告大眾,小心人類發展出「超級人工智能」帶來危機,例如霍金(Stephen Hawking)、蓋茨(Bill Gates)及馬斯克(Elon Musk)等。

可是按照現時的技術發展,這種「超級AI」的威脅真的迫在眉睫嗎?

現時以機器學習為主的技術,使用大量數據及運算訓練出來的演算法往往專門解決一小個範疇的問題。在特定領域中也許有驚人甚至超越人類的表現,然而一旦遇上偏離過往接觸的數據,便有機會出現異常狀況。

例如有人曾發現,如果把Google翻譯的輸入語言設定為毛利文,會把連續15個「dog」翻譯成「世界末日時鐘在十二點三分鐘我們正在體驗世界上的人物和戲劇性的發展」(這個錯誤在報導公開後已修正,但讀者可測試不斷輸入「ag」,並把語言設定為「系統偵測」)。這很可能是毛利文的數據不足,而且系統訓練時只接觸有意義的內容,遇上無意義文字時便會出現與人類不一樣的反應。

「超人類智能」所需的假設

科技雜誌《Wired》創刊主編、數碼文化專家凱利(Kevin Kelly)曾寫過一篇〈超人類AI的迷思〉(The Myth of a Superhuman AI),質疑這種恐懼背後的假設是否成立。凱利指出「超人類智能快將出現」一說有以下五項假設︰

- 人工智能已經比我們聰明,而且以指數速率增長;

- 我們將能製造通用人工智能,像我們的智能一樣;

- 我們能把人類智能放進矽製晶片中;

- 智能可以無限擴張;

- 一旦我們成功製造「超級智能」,它能夠解決我們大部分問題。

然而凱利認為,上述五項假設均沒有足夠證據支持,我們甚至有更好理由相信它們並不成立。以下不逐一詳說,只簡介部份論點(強烈推薦閱讀原文)。

凱利首先提到,把「智能」放在單一維度上列出高低之別,是誤解了智能運作。假如這種看法成立,我們應能按智能高低順序排列「鸚鵡、海豚、馬、松鼠、章魚、藍鯨、貓和大猩猩」,然而目前沒有證據顯示可以如此比較各種動物。牠們各有不同感官和認知能力,在特定任務中可能遠勝人類(例如松鼠能長期記住大量食物儲藏位置),其他任務則可能遠遜人類,差異除源於身體結構外,亦因為心智(mind)像個生態系統,需要多重認知能力共同運作、互相影響。

電腦在運算速度、記憶能力方面無疑遠超人類,機械學習也在多項特定任務中表現良好,而凱利認為未來人類會發明自然界中不存在的認知模式。他以飛機作比喻︰當人類發明飛機時固然受到自然界啟發,源自會飛的生物,但人類發明的飛行模式(使用螺旋槳和固定機翼)乃新事物,生物世界之中並沒有這回事。他估計這些新的思考模式多數是為特定任務而設,也許僅在統計、計算概率時有用的推論;也有時候會屬於複雜的認知能力,讓人類用來解決單靠我們的智能無法處理的問題。凱利認為,因為結合AI能解決更多問題,我們或會認為AI更聰明,但實際上只是跟我們的心智不同,而這個差異正是AI的好處。

即使把「智能能否在單一維度比較高低」這個問題放在一旁,假設AI能夠比人類聰明,凱利仍然要問︰到底「智能」有沒有極限?在物理世界所有特性 ——速度、大小、溫度等——都是有限的,那麼應假設「智能」有個極限。如此一來,「智能」的極限到底在哪?比人類的智能高出多少?為何能相信「智能」可以無限增長?我們似乎沒有好答案,甚至沒有適合的「智能」指標處理。

就算AI能夠變得比人類聰明很多,但「聰明」本身能夠帶來多大進步和影響?也許這個AI非常擅長思考,不過凱利提醒讀者思考只是科學的一部份,還需要結合現實世界的實驗數據——就算現時最聰明的物理學家再聰明多1000倍,沒有大型粒子對撞器也很難得到新知識。當然他並非指AI發展無助科學進步,而是我們不應無根據誇大AI——那怕是「超人類AI」——對解決難題的能力。

看到SMBC這則漫畫,覺得要加插在文章中間。

更值得關注的科技倫理問題

回到當下,現在社會上其實有更多遠比「超級AI滅絕人類」值得關注的科技倫理問題,以下列舉數個例子。

深度造假(deepfake)︰網絡上,有人利用深度學習技術製作「深度造假」色情影片,只要有足夠多的照片,便能把明星以至任何人的臉放進色情片內。這無疑會帶來一種新形態的「復仇色情」(revenge porn,指未經當事人同意發佈其私密影像的報復或欺凌手段),這類「虛構影片」帶來的滋擾一樣嚴重,司法制度以至執法人員須與時並進保障受害人。

深度假新聞︰深度造假技術除了換臉外,還可以修改口形、轉換場境、複製聲線等,使偽造相片及影片變得更簡單,假新聞的成本也變得更低。《BuzzFeed》新聞跟導演皮爾(Jordan Peele)合作,製作一段前美國總統奧巴馬(Barack Obama)提醒公眾關注假新聞的假影片,顯示這項技術的發展水平(而這已經是近兩年前的技術,現時只會更加精密)︰

2019年2月,OpenAI公佈他們訓練出一個表現驚人的無監督語言模型(unsupervised language model)GPT-2,雖然可用來協助寫作,但亦可用來自動產生假新聞,使假新聞網站(或內容農場)變得更大規模、更難辨認。

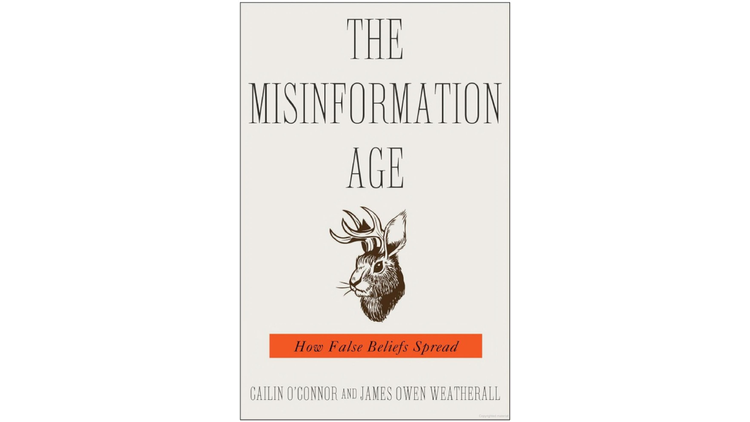

社交媒體的造假與分化︰社交媒體的演算法問題、同溫層效應、假帳號帶風向等已非新鮮事,在可見的將來肯定繼續有人利用社交媒體本身的特性、漏洞,結合日漸精進的造假技術來傳播假訊息、製造輿論和分化群眾。

《Snopes》在2019年11月刊出報導,詳述來自美國的The BL集團(The Beauty of Life)如何造假,更稱此集團為「Facebook上的假新聞帝國」。其後Facebook以參與「協同造假行為」(coordinated inauthentic behavior)為由移除多個與The BL有關的帳戶、專頁及群組,更提到有部分帳戶的個人頭像以人工智能產生,扮成真人貼文。

網站「這個人不存在」(https://thispersondoesnotexist.com/)源源不絕提供以深度學習技術產生的假人頭像,幾可亂真,一如網站名字,圖片中的人並不存在,不過用這類圖片做假帳號頭像的話,一般人不會深究,反倒增加可信程度,又不會被抓到偷其他人照片使用。

無論來自本國抑或外國,國家宣傳機器配合社交媒體的分化技巧、針對式宣傳——讓政治人物可以對不同受眾發放不同訊息——要激發民眾對立亦更為容易。

監控人民︰臉部識別演算法、無處不在的攝錄鏡頭、難以隱藏的網絡足跡,令到民眾可能全天候面對監控。亞馬遜公司(Amazon)為美國一些執法部門提供臉部識別服務,警務人員能實時追蹤任何民眾動向,包括根本未有涉及犯罪行為的公民,例如示威者。在缺乏監管下,有關技術或會協助打壓言論和表達自由。

(按︰經過2019年,這一點相信不用再多解說。)

加強歧視︰深度學習演算法往往被視作一個「黑盒」,意思是外界只能判其輸入、輸出值判斷是否可靠,但難以理解其運作原理。問題是,不少演算法都利用大量數據協助訓練,如果數據本身受社會的歧視及偏見影響,訓練得出的演算法可能「學會」了相同的偏見,應用時加強了歧視對弱勢社群的影響,外界卻難以得悉,甚至誤以為其客觀可靠。

簡言之,以目前技術發展「超級AI」相信還沒有那麼快出現,真要擔心的話我也不阻止,不過強烈建議也花點時間心力,了解一下當下科技帶來的種種問題,有些可謂迫在眉睫。

延伸閱讀

(原刊於Medium)